10月20日報道,今天上午,DeepSeek開源了DeepSeek-OCR模型,首次提出了“上下文光學壓縮(Contexts Optical Compression)”的概念,通過文本轉圖像實現信息的高效壓縮。

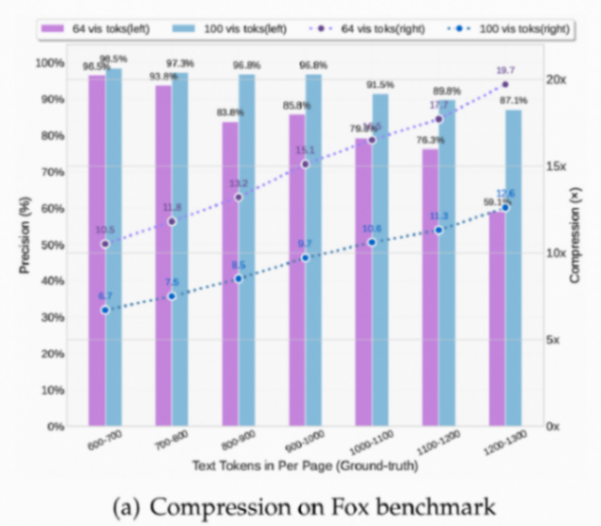

這一方法的可行性已經得到驗證,在10倍壓縮比下,DeepSeek-OCR的解碼精度可達97%,近乎實現無損壓縮;在20倍壓縮比下,精度仍保持約60%。

當把等量的文本token轉化為視覺token(圖像)后,DeepSeek-OCR能用更少的token數表達相近的文本內容,這為解決大語言模型在長文本處理中的高算力開銷提供了新的思路。

除此之外,DeepSeek-OCR還表現出很高的實際應用價值。在OmniDocBench上,它只使用100個視覺token就超越了GOT-OCR2.0(每頁256個token),并且在使用少于800個視覺tokens的情況下,性能超過了MinerU2.0(平均每頁近7000個token)。