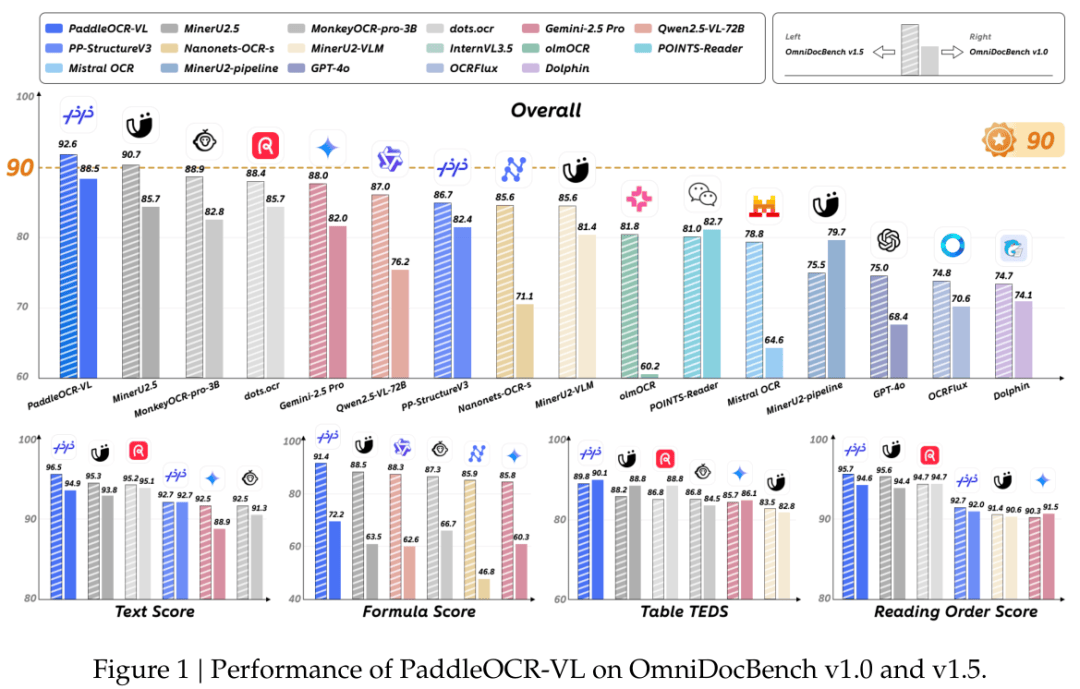

百度用一個(gè)僅0.9B參數(shù)的模型,在權(quán)威的文檔解析評(píng)測(cè)榜單OmniDocBench V1.5上,拿下了92.6分的綜合成績(jī),位列全球第一。

這個(gè)叫作PaddleOCR-VL的模型,發(fā)布不到一天,就在技術(shù)圈的開(kāi)源社區(qū)Hugging Face上沖到了全球熱度榜首。現(xiàn)在仍然霸榜。

它不只是總分高,在文本識(shí)別,公式識(shí)別,表格理解和閱讀順序這四個(gè)文檔解析最核心的能力維度上,全都做到了業(yè)界最佳水平,是目前唯一一個(gè)在這四項(xiàng)上全部登頂?shù)哪P汀?/p>

它還能處理109種語(yǔ)言,從常見(jiàn)的中文,英文,日文,韓文,到結(jié)構(gòu)復(fù)雜的俄語(yǔ)(西里爾字母),阿拉伯語(yǔ),印地語(yǔ)(天城文)和泰語(yǔ),基本覆蓋了全球主要語(yǔ)言體系。

這個(gè)事兒有意思的地方在于,當(dāng)下大家普遍的認(rèn)知是模型參數(shù)量越大,能力越強(qiáng)。百度這個(gè)0.9B參數(shù)的模型能取得這樣的成績(jī),怎么做到的?

庖丁解牛,先把任務(wù)拆開(kāi)

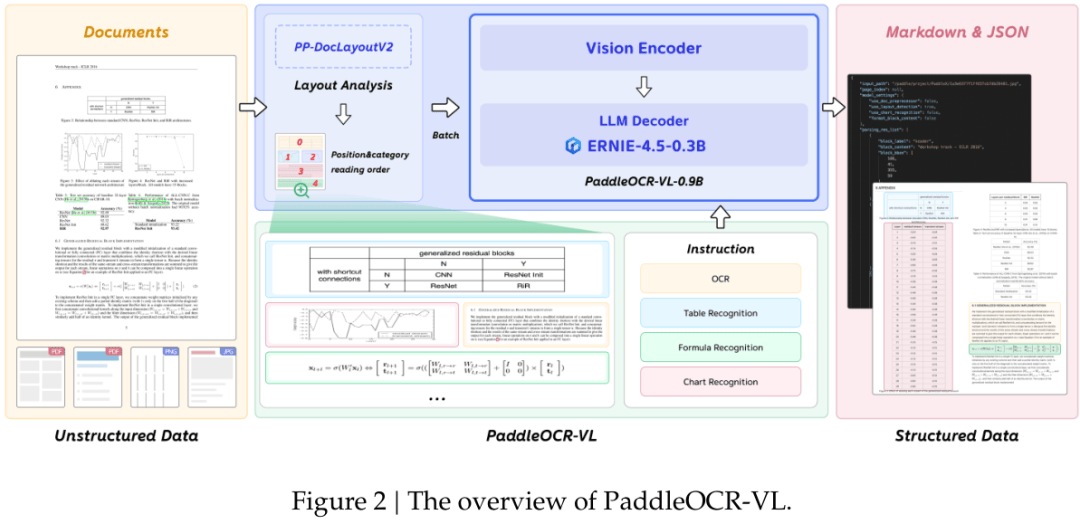

模型能做到又小又強(qiáng),關(guān)鍵在于它的設(shè)計(jì)思路。PaddleOCR-VL沒(méi)有選擇做一個(gè)大而全的端到端模型,把一張文檔圖片直接扔進(jìn)去,讓模型自己搞定所有事。

那種方法聽(tīng)起來(lái)很酷,但在實(shí)際應(yīng)用中常常會(huì)遇到麻煩,比如模型容易產(chǎn)生幻覺(jué),搞錯(cuò)文本的閱讀順序,或者在處理復(fù)雜長(zhǎng)文檔時(shí)計(jì)算成本高得嚇人,難以落地。

PaddleOCR-VL用的是一個(gè)兩階段架構(gòu)。