一種用高數據效率強化學習算法 SAC 訓練流策略的新方案,可以端到端優化真實的流策略,而無需采用替代目標或者策略蒸餾。SAC FLow 的核心思想是把流策略視作一個 residual RNN,再用 GRU 門控和 Transformer Decoder 兩套速度參數化。SAC FLow 在 MuJoCo、OGBench、Robomimic 上達到了極高的數據效率和顯著 SOTA 的性能。

作者來自于清華大學和 CMU,通訊作者為清華大學教授丁文伯和于超,致力于強化學習算法和具身智能研究。

研究背景

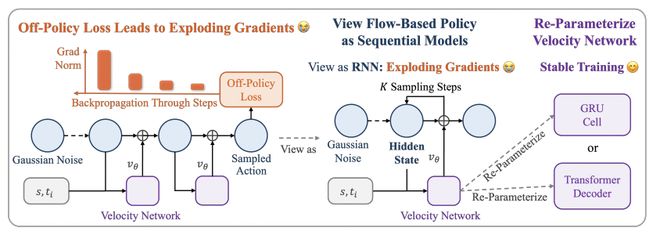

流策略(Flow-based policy)最近在機器人學習領域十分熱門:它具有建模多峰動作分布的表達能力,且比擴散策略更簡潔好用,因此被廣泛應用于先進的 VLA 模型,例如 π_0、GR00T 等。想要跳出數據集的約束,進一步提高流策略的性能,強化學習是一條有效的路,已經有不少工作嘗試用 on-policy 的 RL 算法訓練流策略,例如 ReinFlow [1]、 Flow GRPO [2] 等。但當我們使用數據高效的 off-policy RL(例如 SAC )訓練流策略時總會出現崩潰,因為流策略的動作經歷「K 步采樣」推理,因此反向傳播的「深度」等于采樣步數 K。這與訓練經典 RNN 時遇到的梯度爆炸或梯度消失是相同的。

不少已有的類似工作都選擇繞開了這個問題:要么用替代目標避免對流策略多步采樣的過程求梯度 (如 FlowRL [3]),要么把流匹配模型蒸餾成單步模型,再用標準 off-policy 目標訓練 (如 QC-FQL [4])。這樣做是穩定了訓練,但也拋棄了原本表達更強的流策略本體,并沒有真正在訓練一個流策略。而我們的思路是:發現流策略多部采樣本質就是 sequential model ,進而用先進的 sequential model 結構來穩住訓練,直接在 off-policy 框架內端到端優化真實的流策略。

使用 off policy RL 算法訓練流策略會出現梯度爆炸。本文提出,我們不妨換一個視角來看,訓練流策略等效于在訓練一個 RNN 網絡(循環計算 K 次),因此我們可以用更高效現代的循環結構(例如 GRU,Transformer)。